Gemma 3 270M发布:小而精的AI模型,专为任务微调而生

2025年8月15日

2025年8月14日,Google DeepMind 正式发布 Gemma 3 270M —— 一款专为任务特定微调打造的紧凑型AI模型。它仅有2.7亿参数,却集成了强大的指令理解能力与极致的能效表现,标志着 Gemma 系列正式迈入“小而专”的新阶段。

这不是一个追求参数规模的“巨无霸”,而是一个为高效落地而设计的“特种兵”。它的目标很明确:让开发者用更低的成本、更快的速度,构建真正贴合业务需求的专用AI系统。

从“大而全”到“小而专”:Gemma 的进化之路

过去几个月,Gemma 家族持续进化,迅速成为开源AI生态中的明星系列。截至目前,Gemma 模型下载量已突破 2亿次,广泛应用于云服务器、桌面加速器、移动设备乃至浏览器端。

- Gemma 3:旗舰级模型,面向单GPU/云加速器,性能达到业界领先水平;

- Gemma 3 QAT:量化感知训练版本,显著提升云端推理效率;

- Gemma 3n:专为移动端设计的多模态架构,将实时AI带到边缘设备。

如今,Gemma 3 270M 的加入,进一步丰富了这一“规模矩阵”。它不再追求通用对话能力,而是聚焦于一个核心命题:如何用最小的代价,完成最精准的任务?

Gemma 3 270M:小身材,大能量

如果说大模型是“全能选手”,那么 Gemma 3 270M 就是“专精领域的冠军”。它从设计之初就专注于“任务微调”,兼具高性能与低开销,真正实现了小巧而强大。

1. 架构精巧:2.7亿参数,每一分都用在刀刃上

Gemma 3 270M 的 2.7 亿参数并非平均分配,而是经过精心调配:

- 1.7亿嵌入参数:得益于高达 256K token,模型能精准捕捉专业术语、小语种词汇和罕见表达,为垂直领域微调打下坚实基础;

- 1亿Transformer块参数:继承 Gemma 3 的先进架构,包括旋转位置编码(RoPE)和多查询注意力机制(MQA),确保核心能力不打折。

这种“重嵌入、轻结构”的设计,让它既能理解复杂语义,又不会因冗余参数拖慢推理速度。

2. 能效惊人:端侧运行的“省电王”

对于手机、IoT设备等边缘场景,功耗是生死线。Gemma 3 270M 的 INT4量化版本(量化感知训练检查点)在 Pixel 9 Pro 上的表现令人惊艳:

- 连续对话25轮,仅消耗 0.75% 的电池电量;

- 量化后性能几乎无损,满足生产级部署要求。

这意味着,你可以将微调后的模型直接嵌入手机、手表甚至网页浏览器,实现离线运行 + 超低功耗的双重优势。

3. 指令跟随能力强:开箱即用的“任务助手”

Gemma 3 270M 提供两个版本:

- 预训练模型:作为微调底座,保留了强大的语言理解能力;

- 指令微调模型:已针对“执行明确指令”进行优化,例如“提取实体”“转表格”“分类文本”,无需复杂调参即可投入使用。

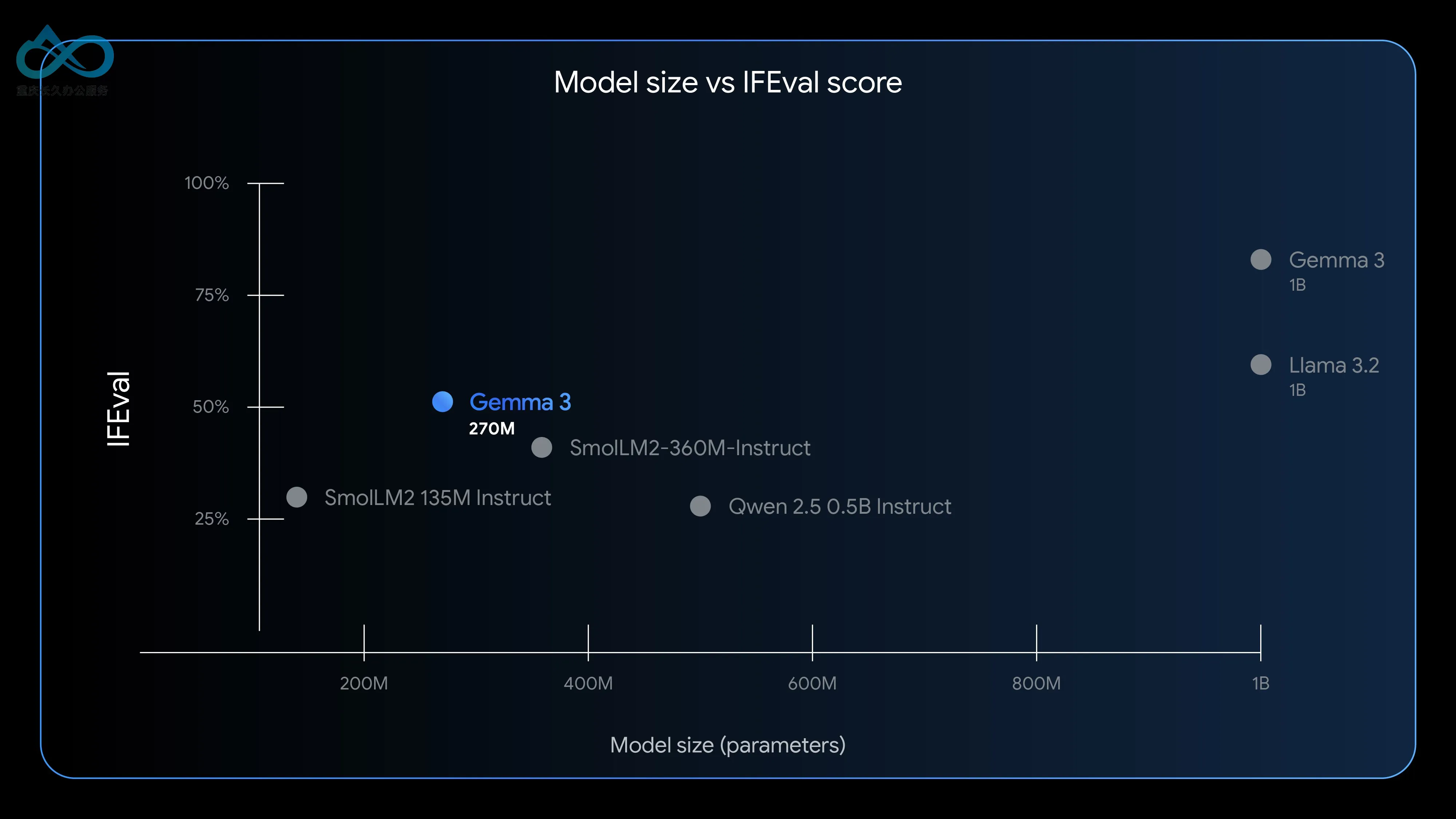

虽然它不适合长篇对话或复杂推理,但在 定义清晰的任务(well-defined tasks)上,表现远超同规模模型。在 IFEval 基准测试中,它刷新了 270M级别模型的指令遵循能力纪录。

4. 一键量化,轻松部署

为了让部署更简单,Gemma 3 270M 提供了 量化感知训练(QAT)检查点,支持 INT4 精度推理:

- 无需额外优化,即可在 CPU、GPU、NPU 上运行;

- 模型体积缩小至原来的 1/4,推理速度提升 3–5倍;

- 完美适配轻量级服务、边缘设备和浏览器环境。

设计哲学:合适的工具,做合适的事

Google DeepMind 在官方博客中写道:

“工程的成功,不在于原始算力有多强,而在于效率是否最优。你不会用大锤去挂相框,也不该用百亿参数模型去做文本分类。”

Gemma 3 270M 的真正价值,在于 用小模型的成本,实现大模型的精度。通过微调,它能在特定任务上反超更大的通用模型。

真实案例见证效率革命

- 企业级应用:Adaptive ML 与 SK Telecom 合作,使用 Gemma 3 4B(比270M大15倍)进行多语言内容审核。结果不仅准确率比某百亿参数闭源模型高出 12% ,成本还降低了 70% 。

- 创意玩法:Hugging Face 团队用 Gemma 3 270M + Transformers.js 开发了一款 睡前故事生成器,完全在浏览器中离线运行,无需依赖云服务,轻量又隐私友好。

什么时候该选 Gemma 3 270M?

如果你的项目符合以下任一场景,它就是你的理想选择:

✅ 高并发、规则明确的任务

如情感分析、实体抽取、查询路由、非结构化数据转结构化等。微调后,准确率可媲美10倍参数的通用模型。

✅ 对延迟和成本极度敏感

在 Cloud Run 云服务上,每千次推理成本不到 0.1美元,端侧延迟低于 100毫秒,适合电商客服、实时审核等高并发场景。

✅ 需要快速迭代验证

270M 模型微调仅需 几小时(使用 Hugging Face 或 UnSloth 框架),可快速测试不同数据策略,告别“训练一周、等待结果”的痛苦。

✅ 重视用户隐私与合规

模型可完全运行在设备本地,处理医疗记录、个人对话等敏感信息时,无需上传云端,轻松满足 欧盟通用数据保护条例(GDPR)、加州消费者隐私法案(CCPA) 等法规要求。

✅ 想构建“专用模型舰队”

用多个微调后的 270M 模型分别处理“订单提取”“评论分类”“投诉识别”等任务,比用一个大模型“一拖多”更高效、更便宜。

如何快速上手?

Google DeepMind 提供了完整的工具链,助你从零到一:

- 下载模型

支持 Hugging Face、Ollama、Kaggle、LM Studio、Docker 等多种渠道,提供预训练与指令微调两个版本。 - 快速试用

可通过 Vertex AI、llama.cpp、LiteRT、Keras、MLX 等工具快速部署和测试。 - 开始微调

使用 Hugging Face Transformers、UnSloth、JAX 等主流框架,结合自定义数据集进行微调。 - 灵活部署

微调后的模型可部署在本地服务器、Google Cloud Run 云服务,或直接嵌入移动端 App 和网页应用(如通过 Transformers.js 实现离线运行)。

结语:AI 的未来,属于“专门化”

Gemma 3 270M 的推出,不只是增加了一个新模型,更是传递一种理念:AI 的价值,不在于“大”,而在于“准” 。

未来的 AI 应用,不再是“一个模型打天下”,而是由无数个小而专的模型组成的智能网络。它们各司其职,高效协作,共同构建更灵活、更经济、更可持续的AI生态。

对开发者而言,Gemma 3 270M 不只是一个“小模型”,更是一块高自由度的积木。你可以用它搭建内容审核系统、自动化客服、数据清洗流水线,甚至创造属于自己的创意玩具。

创新不分大小,关键在于——你是否找到了最合适的工具。

现在,就去 Gemma 生态中,用这 2.7 亿参数的“小模型”,开启你的“大创造”吧!

评论